Face à la prolifération d’applications d’intelligence artificielle censées aider à la détection ou au suivi du coronavirus, il est logique de se demander dans quelle mesure devrions-nous être optimistes quant à l’impact de l’IA dans cette pandémie. Devons-nous avoir confiance en ces outils pour la plupart non testés ?

Les scientifiques du monde entier explorent toutes les options possibles pour lutter contre la pandémie de coronavirus. Parmi ces alternatives, l’intelligence artificielle fait figure de favorite. Dernièrement, on a appris que l’IA était d’ores et déjà utilisée pour détecter de nouvelles molécules capables de traiter le Covid-19, pour scanner les poumons des patients à la recherche de signes de pneumonie liée au coronavirus ou encore pour aider les épidémiologistes ayant commencé à suivre très tôt la propagation du virus. En outre, cette technologie est également à la base de logiciels de suivi capable d’identifier les personnes fébriles ou d’appréhender celles qui enfreignent les règles de confinement.

Dans une longue interview sur le site Recode Vox, Alex Engler, spécialiste de l’intelligence artificielle à la Brookings Institution et professeur à l’université de Chicago, estime qu’en ce qui concerne l’apport de l’intelligence artificielle sur le terrain de la lutte contre la pandémie de coronavirus, le public devrait avant tout modérer ses attentes.

« L’intelligence artificielle peut être utile. Mais il est important de se méfier des entreprises technologiques faisant d’amples déclarations sans fondements sur les capacités de l’IA dans ce domaine. Il faut en outre se demander si ces entreprises possèdent les données et l’expertise nécessaires pour s’assurer que leurs applications sont réellement utiles. »

Selon le spécialiste, l’IA pourrait être utile en marge de la pandémie, mais cette technologie est loin d’être prête à remplacer les experts humains dans la lutte contre le coronavirus.

« Les risques d’une intelligence artificielle sur-typée ne sont pas nouveaux. Mais lors d’une pandémie, lorsque les personnes sont impatientes de trouver des solutions rapides, les dangers de faire confiance à une technologie non éprouvée sont plus grands que jamais », précise le site Recode.

Supercherie ?

Récemment, nous sommes témoins d’une kyrielle de déclarations sur la manière dont l’IA est capable de combattre ou d’aider à lutter contre le coronavirus. Toutefois, il est difficile de déterminer quelles sont vraiment les applications les plus efficaces dans cette croisade.

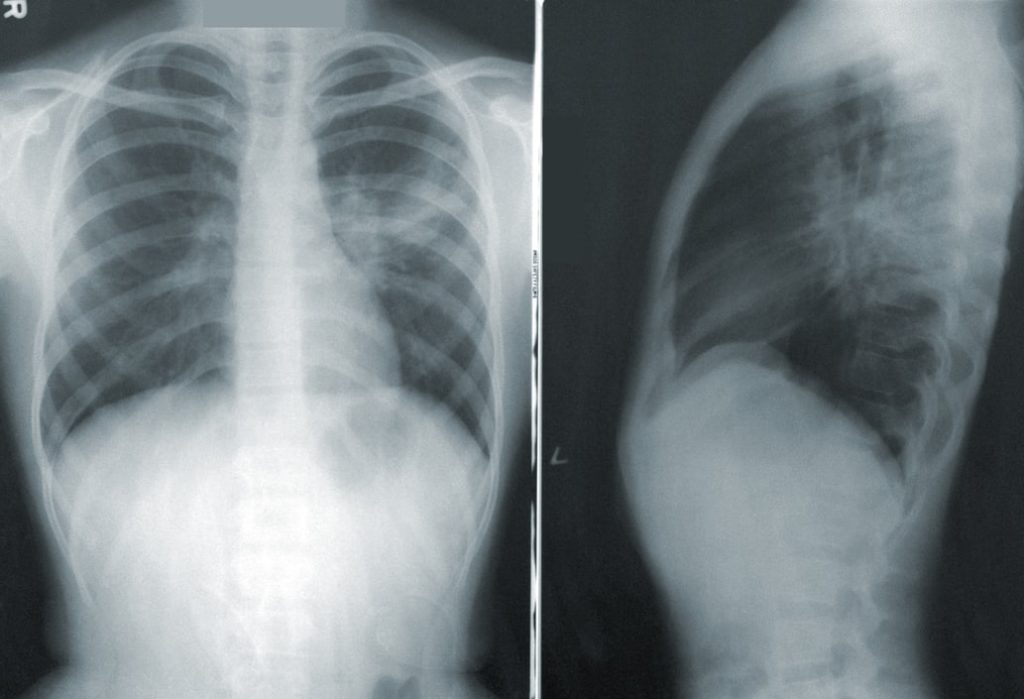

« Certaines ne sont probablement que des supercheries et n’aboutiront jamais. D’autres en revanche sont peut-être une bonne idée. Mais elles sont totalement nouvelles et nous devons être prudents lorsque nous décidons de leur faire confiance, surtout si elles n’ont pas été solidement testées et si elles ne sont pas encore présentes sur le terrain. Je pense par exemple aux diagnostics utilisant des rayons X ou aux tomodensitogrammes de pneumonie ou de coronavirus. »

Alex Engler fait également remarquer qu’il est essentiel de comprendre que l’intelligence artificielle a besoin de l’expertise humaine. Sur le plan de la pandémie de coronavirus, l’IA à elle seule n’est pas utilisée pour deux raisons.

Premièrement, les chercheurs ne disposent pas de beaucoup de données sur la propagation des coronavirus et des épidémies semblables.

« Nous n’avons pas assez de données historiques. Ces données sont accessibles via l’expertise en la matière, via les choses que nous apprenons à partir d’expériences au quotidien. »

Deuxièmement, les enjeux des décisions sont très importants, explique Engler.

« Imaginez vous utilisez l’IA pour diagnostiquer quelqu’un et que vous vous trompez ? En d’autres termes, vous pourriez être préoccupé par un faux négatif. Vous dites que quelqu’un est en bonne santé alors qu’en fait, il a un coronavirus. C’est une énorme erreur à commettre. Il faut donc être très prudents lorsque nous accordons trop d’intérêt à l’IA dans de telles situations. »

« Nous avons le même genre d’inquiétude en ce qui concerne l’approche de tomodensitométrie. Nous pourrons peut-être diagnostiquer un coronavirus avec une tomodensitométrie à un moment donné dans le futur, mais les méthodes ne sont pas encore assez fiables. Nous ne sommes pas encore sûrs qu’elles fonctionnent assez bien. »

Engler cite un autre exemple. Un spécialiste cherche à détecter la fièvre en utilisant l’imagerie thermique. Dans ce cas, il peut commettre une erreur dans l’autre sens. En effet, il pourrait penser que la personne a de la fièvre alors qu’en fait, elle n’en a pas.

« Et sur cette base, vous allez laisser l’IA dicter le fait que les personnes doivent rester en-dehors d’une épicerie ou d’un aéroport ? »

Du pire comme du meilleur

Dans le cadre des solutions d’IA déployées pour combattre la pandémie, les pires exemples proviennent non seulement d’allégations difficiles à croire, mais aussi d’affirmations aux effets secondaires subtils et pernicieux, explique l’expert.

« Certaines personnes ont suggéré que si vous connectiez divers capteurs aux drones, vous pouviez détecter toutes sortes de choses. Les affirmations les plus ridicules que j’ai entendues concernaient le fait que des drones pouvaient non seulement faire de l’imagerie thermique pour détecter si les personnes avaient de la fièvre mais également avoir une idée de leur fréquence respiratoire et de leur fréquence cardiaque. »

« Mais ce qui est pire, c’est que cela justifie également une opportunité de surveillance substantielle, un mécanisme d’état de surveillance. Vous pourriez de la sorte justifier un nouveau dégré de surveillance au sein d’espaces publics, contrôle qui affecte le comportement des personnes, et qui ne correspond pas toujours à la tâche que l’IA prétend pouvoir réaliser », met en garde Axel Engler.

De nombreuses applications d’intelligence artificielle sont également biaisées. L’un des exemples les plus frappants concerne l’algorithme Optum, la filiale d’analyse de données de UnitedHealthcare, société américaine d’assurance et de soins de santé. Cet algorithme est utilisé pour déterminer le risque de futurs besoins en soins de santé. Ce que les chercheurs ont découvert lorsqu’ils ont eu accès à l’algorithme Optum, c’est qu’il était très biaisé lorsqu’il s’agit d’Afro-Américains pour des raisons qui n’étaient pas pertinentes en termes de santé, mais qui étaient davantage liées aux finances et au statut socio-économique. Via des décisions humaines et automatisées, ces algorithmes ont essentiellement plaidé pour moins de soins pour les Noirs américains.

« Dans ce type de système, votre valeur par défaut doit être : il existe des biais jusqu’à ce que vous procédiez à une évaluation rigoureuse afin de montrer que ces derniers ne sont plus présents. Vous en trouverez probablement et vous devrez probablement faire quelques mesures d’atténuation. Donc, en ce qui concerne les premiers algorithmes utilisés pour évaluer le risque de mortalité du coronavirus, la probabilité qu’il y ait des biais subtils est très élevée, surtout lorsque vous considérez des choses telles que les différentes caractéristiques biologiques, des variables appelées biomarqueurs. Ces biomarqueurs peuvent vous aider à deviner qui est le plus susceptible d’être gravement malade, mais ils peuvent également être très trompeurs en termes de signaux non comptabilisés. »

Selon Engler, deux projets d’intelligence artificielle tentant de contrecarrer la pandémie de coronavirus méritent de s’y attarder. Le premier concerne l’IA de DeepMind, la division IA de Google, présentée comme capable de modéliser des protéines du virus.

« Il est possible que ces estimations de la structure des protéines soient utiles pour créer des vaccins et également des traitements », explique-t-il. « Les chercheurs de DeepMind ont immédiatement lancé ce projet après avoir obtenu la composition génétique de Covid-19. Il est donc possible que ces efforts puissent accélérer le développement d’un vaccin ou d’un anticorps thérapeutique qui contribue à contrecarrer les dommages du virus. Il est encore un peu trop tôt pour le dire. Il s’agit d’estimations et ces prévisions doivent être validées expérimentalement. Toutefois, c’est un nouveau développement qui pourrait être très significatif. »

Un autre effort dans la lutte contre le Covid-19 mérite le détour, indique encore l’expert. Il s’agit d’un domaine émergent de l’IA qui consiste à utiliser cette technologie pour analyser de grandes quantités d’articles universitaires. Le fait qu’il existe énormément d’articles de recherche académique, en particulier dans des domaines comme la biomédecine, complique fortement leur consultation ou le fait déterminer leur pertinence.

« Je pense que cela pourrait être utile afin de faciliter la recherche d’articles pertinents et leur catégorisation. Il est peu probable que nos vaccins, nos solutions ou notre compréhension fondamentale de Covid-19 en découlent. Mais cela pourrait aider de manière significative à organiser ce que nous savons. »

Enfin, Alex Engler considère qu’avec le temps l’intelligence artificielle pourrait être significativement utile dans le domaine de l’imagerie médicale. L’IA pourrait être efficace lorsqu’il s’agit d’établir la différence entre la pneumonie bactérienne et la pneumonie associée au coronavirus.

« Ces tâches ne sont pas fondamentalement impossibles pour l’IA. Cela vaut la peine de les approcher dans une perspective sceptique et informée », conclut-il.